Grâce aux avancées spectaculaires dans les domaines de l’apprentissage en profondeur et des réseaux de neurones, des outils comme Midjourney ou Dall-E permettent de créer des images époustouflantes à partir de simples descriptions textuelles. Ces technologies ne se limitent pas aux professionnels du graphisme ; elles sont également accessibles aux amateurs, ouvrant ainsi un monde de créativité et d’innovation.

À l’origine se trouve l’apprentissage machine, où les modèles informatiques apprennent à interpréter et à manipuler des données visuelles. Ces modèles, entraînés avec de vastes ensembles de données d’images, apprennent à reconnaître des motifs et des structures complexes.

Les technologies clés impliquées incluent des réseaux de neurones convolutifs (CNN) et des architectures innovantes telles que les réseaux antagonistes génératifs (GANs) et les modèles de diffusion. Les CNN sont efficaces pour analyser les images, captant des caractéristiques et des motifs à différents niveaux de complexité. Les GANs, quant à eux, utilisent une approche de dualité où un réseau génère des images et l’autre évalue leur réalisme, favorisant ainsi la création de contenus visuels nouveaux et réalistes.

Les modèles de diffusion représentent une autre méthode, où ils génèrent des images en inversant progressivement un processus de dégradation de l’image. Ce mécanisme permet de produire des images d’une qualité et d’un détail impressionnants, en particulier pour des textures et nuances complexes.

Explorons plus en détails ces techniques

L’Apprentissage Profond (Deep Learning)

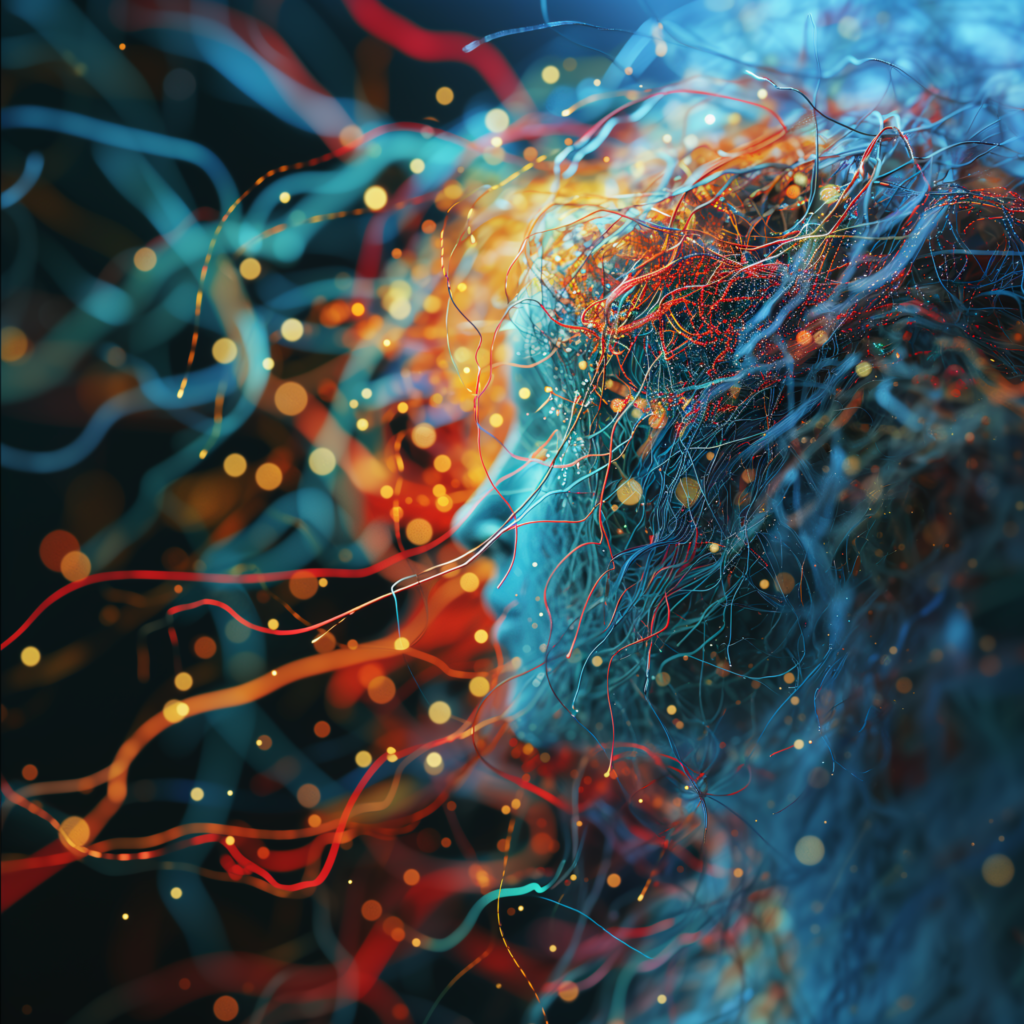

L’apprentissage profond est un sous-domaine de l’apprentissage automatique (machine learning) qui utilise des algorithmes inspirés par la structure et la fonction du cerveau humain, appelés réseaux de neurones artificiels. Ces réseaux sont composés de couches de neurones, chacune effectuant des calculs et des transformations sur les données qui leur sont transmises. L’aspect « profond » de l’apprentissage profond provient du nombre important de ces couches, ce qui permet au modèle de traiter des données de manière plus complexe et nuancée.

Fonctionnement des Réseaux de Neurones

Les réseaux de neurones sont structurés en couches : une couche d’entrée, plusieurs couches cachées et une couche de sortie. Chaque neurone dans une couche reçoit des entrées, les traite en utilisant une fonction d’activation, et transmet le résultat aux neurones de la couche suivante. L’apprentissage se produit en ajustant les poids des connexions neuronales, un processus guidé par une méthode appelée rétropropagation et un algorithme d’optimisation comme le gradient descendant.

Apprentissage Supervisé vs Non Supervisé

- Apprentissage supervisé : Le modèle est entraîné sur des données étiquetées. Il apprend à prédire le résultat ou la catégorie de nouvelles données basées sur cet apprentissage.

- Apprentissage non supervisé : Le modèle explore des données non étiquetées pour découvrir des patterns et des structures cachées sans guidage externe.

Réseaux de Neurones Convolutifs (CNN)

Particulièrement importants dans la génération d’images, les CNN sont un type de réseau de neurones artificiels où les neurones correspondent à des champs réceptifs de manière similaire aux neurones du cortex visuel humain. Ces réseaux sont excellents pour traiter des données qui ont une structure en grille, comme les images. Ils utilisent des opérations de convolution pour filtrer et extraire des caractéristiques des images, les rendant puissants pour des tâches telles que la reconnaissance d’images et la génération d’images.

Réseaux Antagonistes Génératifs (GANs)

Les GANs sont un type de réseau de neurones artificiels utilisés dans l’apprentissage non supervisé. Ils ont été introduits par Ian Goodfellow et ses collègues en 2014. Cette technologie est révolutionnaire dans le domaine de l’IA, notamment pour sa capacité à générer de nouvelles données qui peuvent être indiscernables des données réelles.

Structure des GANs

Un GAN se compose de deux parties principales :

- Le Générateur : Il crée des images (ou d’autres types de données) qui ressemblent aux exemples réels de l’ensemble de données d’entraînement. Le générateur apprend à produire des données de plus en plus convaincantes au fil du temps.

- Le Discriminateur : Il évalue les images, les distinguant comme étant « réelles » (provenant de l’ensemble de données d’entraînement) ou « fausses » (produites par le générateur). Le discriminateur s’affine pour devenir meilleur à détecter les faux.

Processus d’Apprentissage

Dans un GAN, le générateur et le discriminateur sont entraînés simultanément dans un jeu de type chat et souris. Le générateur tente de tromper le discriminateur en produisant des images de plus en plus réalistes, tandis que le discriminateur s’efforce d’améliorer sa capacité à distinguer le vrai du faux. Cet entraînement concurrentiel améliore les capacités des deux réseaux jusqu’à ce que le générateur produise des images presque indiscernables des réelles.

Les Modèles de Diffusion

Les modèles de diffusion sont une classe de modèles génératifs en apprentissage profond. Ils sont utilisés pour générer des données de haute qualité, telles que des images, en simulant un processus de diffusion. Ce processus consiste à transformer progressivement un échantillon aléatoire en une structure organisée (comme une image), en suivant un chemin soigneusement orchestré.

Fonctionnement des Modèles de Diffusion

Le fonctionnement des modèles de diffusion peut être divisé en deux phases principales : la phase de diffusion (ou de bruitage) et la phase de dédiffusion (ou de génération).

- Phase de Diffusion : Dans cette phase, le modèle ajoute progressivement du bruit à une image de départ, la dégradant jusqu’à ce qu’elle devienne un bruit aléatoire. Cette étape est réalisée en plusieurs itérations, où à chaque itération, une petite quantité de bruit est ajoutée.

- Phase de Dédiffusion : C’est la phase de génération où le modèle apprend à inverser le processus de bruitage. En partant du bruit aléatoire, le modèle utilise un réseau de neurones pour prédire et annuler le bruit ajouté progressivement, reconstruisant ainsi l’image d’origine ou une nouvelle image basée sur des instructions spécifiques.

Importance des Modèles de Diffusion dans la Génération d’Images

Les modèles de diffusion se sont révélés particulièrement efficaces pour générer des images de haute qualité. Ils peuvent créer des images réalistes et détaillées, et sont particulièrement bons pour gérer les textures et les détails fins. Cela les rend idéaux pour des applications telles que la création artistique, la conception de produits, et même la recherche scientifique où la précision des images est cruciale.

Avantages des Modèles de Diffusion

- Haute Qualité des Images : Ils produisent des images avec des détails fins et une qualité visuelle élevée.

- Flexibilité : Ils sont capables de générer une grande variété d’images en modifiant les conditions de génération.

- Contrôle du Processus de Génération : La possibilité de réguler le processus de diffusion et de dédiffusion offre un contrôle créatif accru.

Etapes dans la génération d’image

Collecte et Préparation des Données

- Collecte de Données : Tout commence par la collecte d’un grand ensemble de données d’images. Ces images peuvent varier considérablement, selon le type d’images que l’on souhaite générer.

- Nettoyage et Prétraitement : Les images sont ensuite nettoyées et prétraitées. Cela inclut des tâches comme le recadrage, la normalisation, et parfois l’étiquetage des images pour la formation de modèles supervisés.

Conception du Modèle

- Choix de l’Architecture : Selon l’objectif, on choisit une architecture de réseau de neurones appropriée. Pour la génération d’images, des architectures comme les réseaux de neurones convolutifs (CNN), les GANs ou les modèles de diffusion sont souvent utilisées.

- Configuration du Modèle : Cette étape implique la configuration des paramètres du modèle, comme le nombre de couches, la taille des filtres dans les CNN, et d’autres hyperparamètres.

Entraînement du Modèle

- Apprentissage : Pendant l’entraînement, le modèle apprend à reconnaître et à reproduire des patterns dans les données d’images. Pour les GANs, cela inclut l’entraînement simultané du générateur et du discriminateur.

- Validation et Ajustement : Le modèle est régulièrement validé sur un ensemble de données distinct pour s’assurer qu’il généralise bien et ne surapprend pas. Des ajustements sont effectués au besoin.

Génération d’Images

- Génération Basée sur le Texte/Entrée : Pour des modèles comme DALL-E, une description textuelle est convertie en image. Pour d’autres modèles, cela peut impliquer l’alimentation du modèle avec un type d’entrée spécifique (par exemple, du bruit aléatoire pour les GANs).

- Processus de Génération : Le modèle applique ce qu’il a appris pour générer une nouvelle image. Dans les GANs, le générateur crée des images que le discriminateur évalue, tandis que dans les modèles de diffusion, le processus de débruitage graduel est utilisé.

Post-Traitement et Optimisation

- Raffinement des Images : Les images générées peuvent être raffinées ou retouchées pour améliorer la qualité ou l’esthétique.

- Optimisation du Modèle : Basé sur les résultats, le modèle peut être davantage optimisé pour améliorer la qualité de la génération d’images.

Évaluation et Déploiement

- Évaluation : Les images générées sont évaluées pour leur qualité, leur réalisme, et leur pertinence par rapport aux entrées fournies.

- Déploiement : Une fois satisfaisant, le modèle peut être déployé pour une utilisation pratique, que ce soit dans une application web, une plateforme de création de contenu, ou autre.

les technologies de génération d’images par l’intelligence artificielle, telles que les réseaux de neurones convolutifs, les GANs, et les modèles de diffusion, représentent une avancée significative dans le domaine de la création numérique. Ces outils, allant de Midjourney à Dall-E, ont démocratisé l’accès à la création d’images de haute qualité, rendant ces capacités disponibles non seulement aux professionnels du graphisme mais également aux amateurs. Cette ouverture crée un monde foisonnant de créativité et d’innovation, accessible à un public plus large.

Il est important de reconnaître que, bien que puissants, ces modèles peuvent parfois produire des résultats inattendus, surtout face à des entrées ambiguës ou complexes. Ceci souligne l’importance de la supervision et de l’intervention humaine, notamment dans le processus de post-traitement des images. L’humain joue un rôle crucial dans l’interprétation, le peaufinage et la contextualisation des résultats pour garantir leur pertinence et leur qualité.

En conclusion Il convient de noter que l’utilisation de ces technologies doit être guidée par des considérations éthiques et responsables. Des questions telles que les droits d’auteur, la représentation éthique et la prévention de la désinformation sont primordiales pour une utilisation consciente et responsable de l’IA dans la création d’images.

NEWSLETTER IA

Restez en veille sur l'IA avec notre Newsletter

Tous les mois, les news de l'IA et nos derniers articles, directement dans votre boite mail

AUDIT IA GRATUIT

Découvrez comment l'IA peut transformer votre business en 30 secondes

⚡ Résultats immédiats

🎯 Conseils personnalisés

💰 100% Gratuit

Autres articles à découvrir

Générer un logo avec l’IA : Une bonne idée ?

L’intelligence artificielle a boulversé le domaine de la création graphique. Nous l’avons tous découvert cette année avec les outils de génération d’image tels que Midjourney ou DallE-3. L’IA a également …

Upscaling d’image : 10 meilleurs outils IA gratuits pour améliorer vos photos

Comment l’upscaling d’image fonctionne-t-il ? L’upscaling d’image par l’IA ne se limite pas à ajouter plus de pixels. Il réinterprète l’image originale pour y inclure des détails qui n’existaient pas …

L’IA au Service de Vos Présentations : Découvrez Gamma

Imaginez un outil qui vous permet de transformer vos idées brutes en présentations visuellement époustouflantes, sans avoir à passer des heures à peaufiner chaque détail. C’est exactement ce que Gamma …