L’installation locale de DeepSeek-R1 offre une solution puissante pour bénéficier des capacités avancées de ce modèle tout en conservant un contrôle total sur vos données. Grâce à LM Studio, une interface utilisateur conviviale, vous pouvez facilement télécharger et exécuter des modèles de langage de grande taille (LLM) localement. Découvrez les avantages et suivez ce guide étape par étape pour une installation réussie de Deepseek-R1.

Pourquoi installer DeepSeek-R1 en local ?

L’installation locale de DeepSeek-R1 présente plusieurs avantages significatifs :

- Confidentialité et sécurité : Aucune donnée n’est envoyée vers un serveur externe, garantissant que vos informations restent sur votre machine. Idéal pour les entreprises et les projets sensibles.

- Temps de réponse ultra-rapide : Pas de latence liée aux API ou aux serveurs distants. L’inférence est instantanée avec un GPU performant (ex. RTX 4090, M2 Ultra).

- Économies sur les coûts des API : Évitez les frais récurrents associés à l’utilisation de modèles comme GPT-4 ou Claude via API.

- Personnalisation et fine-tuning : Ajustez DeepSeek-R1 selon vos besoins spécifiques, ajoutez des connaissances particulières, et modifiez les prompts systèmes pour un comportement adapté.

- Intégration avec d’autres outils : Compatible avec des workflows automatisés sur Notion, Obsidian, Make.com, etc. Utilisez LM Studio pour une interface intuitive.

En bref : Les avantages de DeepSeek-R1

DeepSeek-R1 est un modèle open-source conçu pour offrir des performances avancées en traitement du langage naturel (NLP) :

- Excellente performance en génération de texte : Optimisé pour des réponses rapides et précises, excelle dans la rédaction, la programmation, l’analyse et l’assistance conversationnelle.

- Optimisé pour une exécution efficace : Disponible en différentes tailles (7B, 14B, 32B, 70B), adaptable aux ressources matérielles disponibles.

- Open-source et améliorable : Transparence totale et possibilité d’ajuster le modèle pour des besoins spécifiques.

Guide d’installation de DeepSeek-R1 avec LM Studio

Étape 1 : Télécharger et installer LM Studio

- Accédez au site officiel de LM Studio : lmstudio.ai.

- Téléchargez la version appropriée pour votre système d’exploitation (Windows, macOS ou Linux).

- Installez l’application en suivant les instructions spécifiques à votre plateforme.

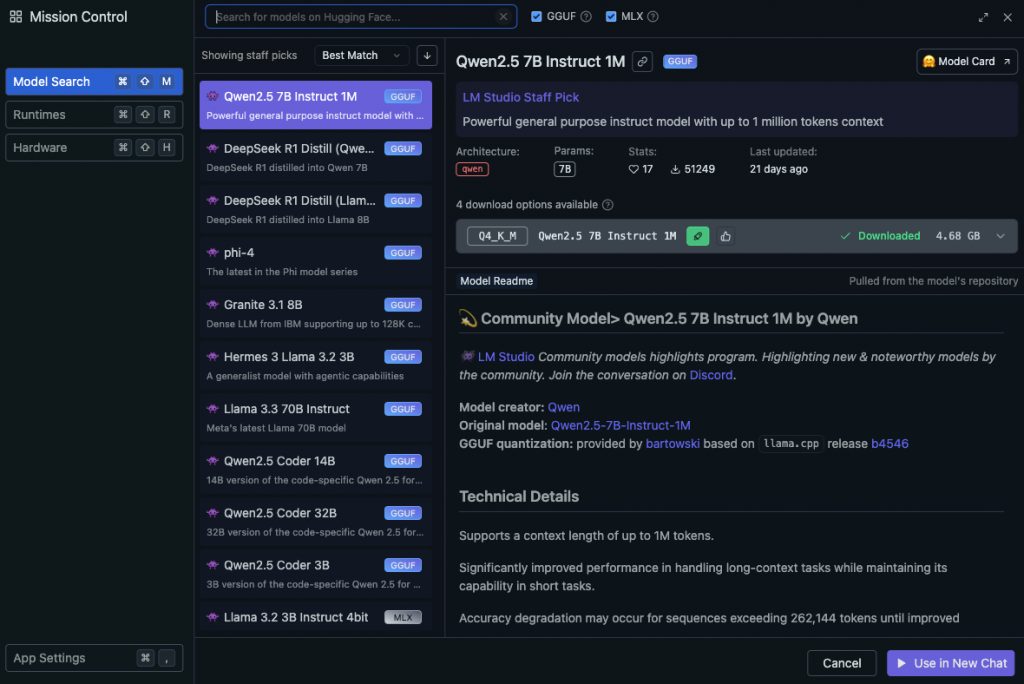

Étape 2 : Lancer LM Studio et télécharger DeepSeek-R1

- Ouvrez LM Studio.

- Accédez à l’onglet « Discover » pour accéder au catalogue de modèles disponibles.

- Recherchez « DeepSeek-R1 » et sélectionnez la version adaptée à vos ressources matérielles.

- Cliquez sur « Download » pour télécharger le modèle sélectionné.

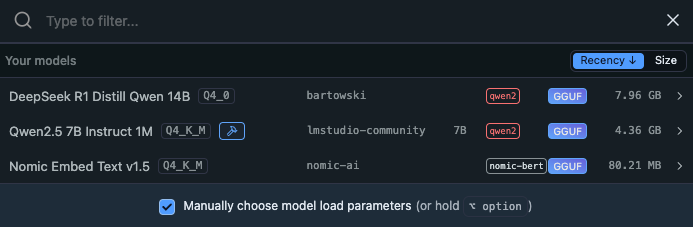

Étape 3 : Charger et utiliser le modèle DeepSeek-R1

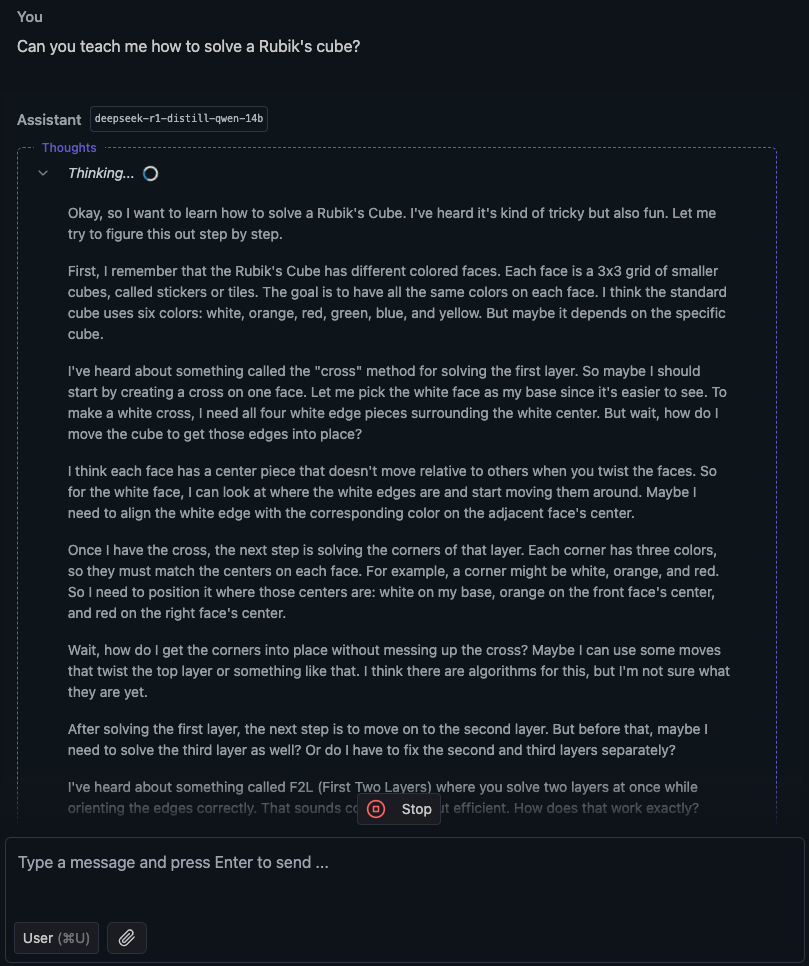

- Allez dans l’onglet « Chat » de LM Studio.

- Sélectionnez le modèle DeepSeek-R1 que vous venez de télécharger.

- Le modèle se chargera en mémoire. Ce processus peut prendre quelques instants en fonction de la taille du modèle et des ressources de votre système.

- Commencez à interagir avec le modèle en saisissant vos messages dans le champ de texte prévu à cet effet.

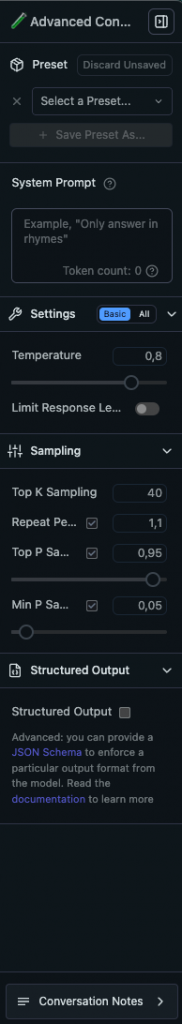

Paramètres avancés dans LM Studio

Pour optimiser votre expérience avec DeepSeek-R1 dans LM Studio, explorez les paramètres avancés qui vous permettent de personnaliser le comportement du modèle selon vos besoins.

- Preset (Préréglage)

- Sélection d’un preset : Enregistrez et chargez différents préréglages pour ajuster rapidement les paramètres en fonction de vos besoins (création, analyse, dialogue, etc.).

- Bouton « Save Preset As » : Enregistrez des configurations spécifiques pour une réutilisation rapide.

- System Prompt

- Message système : Influence la façon dont le modèle répond.

- Exemple : « Réponds uniquement en français » ou « Fais des réponses détaillées et techniques ».

- Settings

- Temperature

- Définit la créativité du modèle.

- Valeur basse (0.2 – 0.5) : Réponses plus déterministes et cohérentes.

- Valeur élevée (0.7 – 1.2) : Réponses plus aléatoires et créatives.

- Limit Response Length

- Limite la longueur de la réponse pour éviter des réponses trop longues.

- Temperature

- Sampling

- Top K Sampling

- Détermine le nombre de tokens considérés à chaque étape.

- Valeurs basses (5-20) : Plus restrictif, réponses plus cohérentes.

- Valeurs élevées (40-100) : Plus de diversité dans les réponses.

- Repeat Penalty

- Pénalise la répétition de mots pour éviter les boucles dans les réponses.

- Valeur recommandée : 1.1 – 1.2 pour un bon équilibre.

- Top P Sampling

- Réduction de la plage des tokens sélectionnés en gardant seulement ceux avec une somme de probabilités de 95 %.

- Valeur recommandée : 0.9 – 0.95 pour du texte fluide.

- Min P Sampling

- Ajuste la probabilité minimale d’un token pour être sélectionné.

- Valeur recommandée : 0.01 – 0.05.

- Top K Sampling

- Structured Output

- JSON Schema : Activez cette option pour forcer un format de sortie structuré (ex. JSON). Utile pour des intégrations automatiques ou l’analyse de données.

Comment choisir le modèle adapté à votre matériel ?

Pour optimiser l’utilisation de DeepSeek-R1 en fonction de vos capacités matérielles, voici un tableau détaillé avec des recommandations pour les configurations Windows et macOS.

| Modèle | Paramètres | RAM | GPU/VRAM Recommandé | Config Mac Recommandée | Remarques |

|---|---|---|---|---|---|

| DeepSeek-R1 1.5B | 1,5 milliards | 8 Go | NVIDIA GTX 1660 (6 Go VRAM) | MacBook Air M2/M3 avec 8 Go de RAM | Idéal pour des tâches légères et des tests initiaux. |

| DeepSeek-R1 7B | 7 milliards | 16 Go | NVIDIA RTX 3060 (12 Go VRAM) | MacBook Pro M2/M3 avec 16 Go de RAM | Bon équilibre entre performance et ressources pour des usages modérés. |

| DeepSeek-R1 8B | 8 milliards | 16 Go | NVIDIA RTX 3070 (8 Go VRAM) | MacBook Pro M2/M3 avec 16 Go de RAM | Légèrement plus performant que le modèle 7B, adapté pour des tâches plus complexes. |

| DeepSeek-R1 14B | 14 milliards | 32 Go | NVIDIA RTX 3080 (10 Go VRAM) | MacBook Pro M2/M3 Pro avec 32 Go de RAM | Convient pour des applications nécessitant une grande précision et des contextes étendus. |

| DeepSeek-R1 32B | 32 milliards | 64 Go | NVIDIA RTX 4090 (24 Go VRAM) | Mac Studio M2 Max/Ultra | Pour des utilisations intensives et des besoins en traitement de données massives. |

| DeepSeek-R1 70B | 70 milliards | 128 Go | NVIDIA A100 (40/80 Go VRAM) | Mac Studio M2 Ultra | Réservé aux configurations haut de gamme pour des performances maximales et des analyses avancées. |

Remarques supplémentaires

- Quantification des modèles : Utiliser des versions quantifiées des modèles (par exemple, en 4 bits) peut réduire les besoins en mémoire et en VRAM, permettant ainsi d’exécuter des modèles plus grands sur des configurations matérielles moins puissantes.

- Performances sur Windows : Les utilisateurs de Windows doivent s’assurer que leur GPU est compatible et dispose de la VRAM nécessaire pour le modèle choisi. Les cartes graphiques NVIDIA récentes, comme les séries RTX 30 et 40, sont généralement recommandées pour des performances optimales.

- Configurations Mac : Les Mac équipés de puces Apple Silicon (M1, M2, M3, M4) avec la quantité de RAM spécifiée peuvent exécuter les modèles correspondants. Les modèles plus grands nécessitent des configurations plus robustes, comme le Mac Studio avec puce M2 Ultra.

- Utilisation de l’accélération Metal : Pour les utilisateurs de macOS équipés de puces Apple Silicon, l’activation de l’accélération Metal dans LM Studio peut améliorer les performances en exploitant au mieux les capacités matérielles de votre Mac.

Références utiles

- LM Studio : Site officiel de LM Studio pour télécharger l’application et accéder aux guides d’installation.

- Documentation DeepSeek-R1 : Consultez les ressources officielles de DeepSeek pour des informations techniques détaillées sur les modèles et leurs configurations.

- Forums et communautés : Participez à des forums comme Reddit r/MachineLearning pour des conseils et des retours d’expérience d’autres utilisateurs.

En suivant ces recommandations, vous pourrez choisir le modèle DeepSeek-R1 le mieux adapté à votre matériel, garantissant ainsi une performance optimale pour vos besoins spécifiques en intelligence artificielle.

FAQ : Installer DeepSeek-R1 en Local avec LM Studio

Si vous hésitez à installer DeepSeek-R1 en local avec LM Studio, voici une FAQ qui répond à des questions courantes et vous aide à prendre une décision éclairée.

Pourquoi devrais-je installer DeepSeek-R1 en local plutôt que d’utiliser un service cloud ?

Installer DeepSeek-R1 en local vous offre un contrôle total sur vos données, garantissant la confidentialité et la sécurité. Vous évitez les frais récurrents liés aux API cloud et bénéficiez de temps de réponse plus rapides grâce à l’absence de latence réseau.

Quels sont les avantages de DeepSeek-R1 par rapport à d’autres modèles de langage ?

DeepSeek-R1 est un modèle open-source optimisé pour des performances avancées en traitement du langage naturel. Il est disponible en différentes tailles, ce qui permet de l’adapter aux ressources matérielles disponibles. De plus, il est personnalisable et peut être ajusté pour des besoins spécifiques.

Mon matériel est-il suffisant pour exécuter DeepSeek-R1 ?

Les exigences matérielles varient selon la taille du modèle que vous souhaitez utiliser. Pour les modèles plus petits (comme 7B), une machine avec 16 Go de RAM et une carte graphique comme la NVIDIA RTX 3060 est suffisante. Pour des modèles plus grands, des configurations plus robustes sont nécessaires. Consultez le tableau de correspondance pour plus de détails.

Est-ce difficile d’installer et de configurer LM Studio ?

Non, l’installation de LM Studio est simple. Il suffit de télécharger l’application depuis le site officiel et de suivre les instructions spécifiques à votre système d’exploitation. La configuration est intuitive, avec des options de préréglage pour différents cas d’utilisation.

Puis-je personnaliser les réponses du modèle ?

Oui, LM Studio permet de personnaliser les réponses du modèle en ajustant divers paramètres comme la température, le top-k sampling, et en utilisant des prompts système. Vous pouvez enregistrer ces configurations pour une utilisation future.

Quels types de tâches DeepSeek-R1 peut-il accomplir ?

DeepSeek-R1 excelle dans diverses tâches telles que la rédaction, la programmation, l’analyse de texte, et l’assistance conversationnelle. Il peut également être utilisé pour des analyses techniques et des générations créatives.

Comment puis-je m’assurer que mes données restent privées ?

En exécutant DeepSeek-R1 localement, vos données ne quittent jamais votre machine. Cela élimine les risques de fuite de données associés aux services cloud et garantit une confidentialité totale.

LM Studio est-il compatible avec mon système d’exploitation ?

LM Studio est compatible avec Windows, macOS et Linux. Vous pouvez télécharger la version appropriée pour votre système d’exploitation depuis le site officiel.

Puis-je utiliser DeepSeek-R1 sans connaissances techniques approfondies ?

Oui, LM Studio est conçu pour être convivial, même pour les utilisateurs non techniques. L’interface intuitive et les options de préréglage facilitent la configuration et l’utilisation du modèle sans nécessiter de compétences avancées.

Existe-t-il une communauté ou un support pour LM Studio et DeepSeek-R1 ?

Oui, vous pouvez trouver du support et des conseils en participant à des forums comme Reddit r/MachineLearning ou en consultant la documentation officielle de LM Studio et DeepSeek-R1. La communauté est active et peut fournir des retours d’expérience précieux.

Articles Similaires

WordPress, Headless ou IA sur mesure : quel CMS choisir en 2026 ?

Pendant 20 ans, la réponse était simple : WordPress. En 2026, le paysage a radicalement changé. Headless CMS, backends IA sur mesure, agents autonomes… Ce guide vous aide à faire…

Quand l’IA quittera la terre : Le plan d’Elon Musk expliqué

Pendant vingt ans, la Silicon Valley a cru que le logiciel allait dévorer le monde. Cette certitude absolue dans la puissance du code se heurte aujourd’hui à une réalité beaucoup…